Un estudi amb IA revela que la desinformació sobre la DANA provoca por en X i ràbia en TikTok

Les faules sobre la DANA han inundat les xarxes socials des del primer moment, intensificant el desassossec entre la ciutadania i afavorint la viralització de continguts enganyosos difosos pels que van aprofitar la tragèdia com a caldo de cultiu. Els pseudoperiodistes, civils amb comptes anònims, i fins i tot polítics ultres –tots ells englobats en la coneguda com a fachosfera– van ser alguns dels protagonistes que no van dubtar a imposar una lògica fal·laç sobre el que passava en l’àrea metropolitana de València.

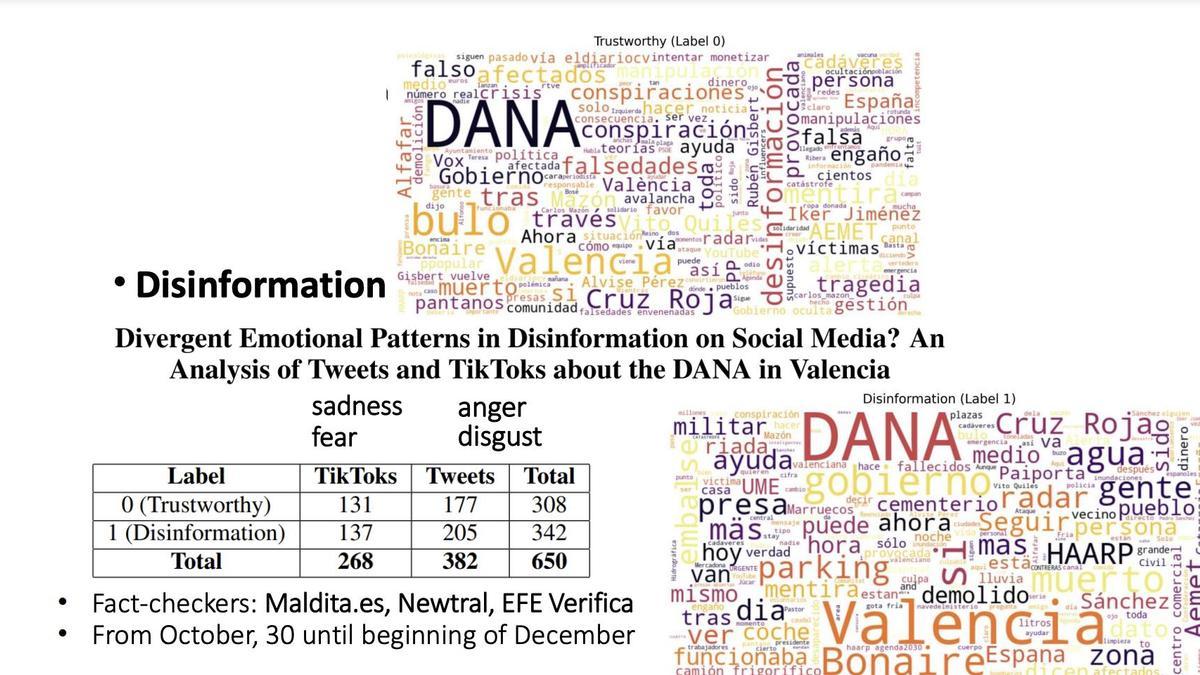

Els discursos amb un to i veu més emocionals, “experiències personals” que afirmaven que hi havia morts en el pàrquing de Bonaire o emocions diferenciades com la ira en continguts de TikTok o la por en X són algunes de les conclusions extretes d’un recent estudi sobre “Patrons emocionals divergents en la desinformació en les xarxes socials. Una anàlisi de tuits i tiktoks sobre la DANA a València” dirigit pels investigadors de la Universitat Politècnica de València Paolo Rosso i Iván Arcos, juntament amb Ramón Salaverría, de la Universitat de Navarra, i publicat per l’Iberian Digital Media Observatory (IBERIFIER), organisme cofundat per la Comissió Europea en col·laboració amb l’European Digital Media Observatory (EDMO).

“Ens ha impactat com s’ha jugat amb les emocions de la gent arran de la desgràcia”, explica Rosso, també membre de la fundació sense ànim de lucre ValgrAI (Valencian Graduate School and Research Network of Artificial Intelligence), en una conversa telefònica amb aquest mitjà. Arran d’aquest punt de partida, els experts van voler analitzar els continguts tant de la plataforma TikTok com la que controla Elon Musk: “Volíem analitzar quins patrons lingüístics i quins patrons emocionals s’utilitzaven en aquests vídeos ja detectats com a desinformacions pels verificadors (Maldita.es, Newtral i EFE Verifica) usats; i, d’altra banda, classificar de manera automàtica per a veure si a partir d’unes mostres amb paraules clau es podia recuperar contingut relacionat amb la DANA, però sense informació falsa per a passar una part d’aquests exemples als models d’IA per a comprovar si eren capaços d’aprendre a discriminar”.

En aquest sentit, l’investigador de la UPV insisteix que els fact-checkers d’aquestes empreses solen estar “desbordats” per la quantitat ingent d’informacions per a verificar que circulen per les xarxes, per la qual cosa el model GPT-4o Few-Shot podria ajudar en l’automatització de l’etiquetatge dels continguts i poder “detectar faules en temps real”. “És una ajuda indubtable en el seu ofici. Ens ha interessat veure fins a quin punt el model era capaç d’etiquetar una cosa com a faula o no faula. Anàvem amb expectatives baixes, però ha sigut millor del que esperàvem”, assevera.

Paraules clau com Vito Quiles, manipulacions i música dramàtica

De manera manual, els investigadors van apuntar un total de 650 publicacions per a discernir entre contingut veraç i desinformacions, a través d’un mètode qualitatiu (anàlisi de narratives, revisió manual de dades i observació d’estratègies de desinformació) i quantitatiu (models d’IA, estadístiques, detecció d’emocions i mètriques de precisió).

L’informe reforça el que defensen nombrosos estudiosos sobre el fet que les emocions són una estratègia habitual en els discursos falsos, no obstant això, aquest treball afig que cal tindre en compte la manera com s’opera en cadascuna d’aquestes plataformes. A més, a través de l’anàlisi lingüística –utilitzant el diccionari LIWC– s’ha pogut demostrar que el contingut contrastat i rigorós usa un llenguatge “més articulat i fàctic”, a diferència de les desinformacions, que recorren a “manipulacions, negacions, paraules perceptives, música dramàtica i anècdotes personals”.

Així mateix, en les paraules clau triades, Rosso, durant l’entrevista, manifesta que es van seleccionar etiquetes que causaren un impacte entre la societat o que pogueren tindre contingut enganyós. Vito Quiles, Alvise Pérez o Bonaire són algunes de les emprades en l’extracció de dades. Per a fer-ho, es van fer servir crawlers (rastrejadors web que naveguen per Internet seguint enllaços d’una pàgina a una altra i les indexen) per a extraure el contingut amb aquestes paraules en X i TikTok, i després d’això, es va avaluar el possible biaix de la mostra amb l’Índex de Raresa (Weirdness Index, WI) per a verificar si les paraules clau influïen en la selecció de dades i comparar el registre amb una mostra de control basada en termes més neutres com ara DANA València.

“Molts dels missatges, a més de suscitar aquestes emocions entre la ciutadania, tenien com a finalitat criticar les actuacions del Govern central, més que les de la Generalitat. Això m’ha cridat molt l’atenció”, confessa l’investigador de ValgrAI. “És important que la gent siga conscient que, en moments vulnerables i de pànic, s’aprofiten de les nostres emocions”, destaca. L’estudi, publicat per Iberifier, es presentarà en ICAART 2025 (Porto), un congrés internacional amb experts en intel·ligència artificial que es durà a terme entre el 23 i el 25 de febrer de 2025.

0